| E' fuori discussione che la causa

prima degli tsunami debba essere ricercata soprattutto nei terremoti. Qualche volta ci

mettono del loro anche le eruzioni vulcaniche e altri avvenimenti più o meno

imprevedibili (vedi l'episodio avvenuto a Lituya Bay nel 1958). A memoria d'uomo,

comunque, non si ricorda proprio nessuno tsunami provocato dalla caduta di un oggetto

celeste. Nonostante questo, però, lo

tsunami da impatto non può essere considerato completamente estraneo al nostro pianeta,

se non altro perchè la maggior parte del globo terrestre è occupata dalle distese marine

e questo le rende il bersaglio privilegiato di un potenziale oggetto celeste.

Una seconda considerazione ci viene suggerita dall'estrema pericolosità che un simile

avvenimento riveste per la vita umana. Gran parte della popolazione mondiale, infatti,

vive in prossimità delle coste e tali insediamenti verrebbero letteralmente spazzati via

dalla potenza dell'onda innescata dall'impatto di un oggetto in mare (per un'analisi più

accurata si può consultare la pagina Tsunami da impatto).

A differenza di quanto avviene per un impatto

sulla terraferma, però, le indicazioni relative agli tsunami da impatto sono quasi

inesistenti. Ci sono dati oggettivi che indicano come in passato si siano certamente

verificati tsunami di smisurata potenza, ma nulla che possa collegarne l'origine ad un

impatto celeste. Siamo ben lontani da quanto avviene per gli impatti sulla terraferma, le

cui cicatrici (i crateri) consegnano agli studiosi un'enorme mole di indicazioni sulla

natura dell'oggetto celeste, sull'epoca dell'evento e sui parametri fisici che lo hanno

caratterizzato.

Se si vuole capire qualcosa di più sul meccanismo dello tsunami da impatto l'unica strada

percorribile è quella della simulazione computerizzata.

I primi importanti lavori in questa direzione sono senza dubbio quelli di Jack Hills e

Chales Mader (Los Alamos National Laboratory) e di Dave Crawford (Sandia National

Laboratories) presentati alla comunità scientifica a metà degli anni '90.

Le simulazioni dell'evento erano effettuate connettendo assieme i risultati di tre

differenti programmi: il primo si occupava di simulare l'impatto e la creazione della

cavità, il secondo era dedicato a studiare come il collasso dei muri d'acqua innescasse

lo tsunami ed il terzo, infine, seguiva il propagarsi dell'onda nell'oceano. Simulazioni

efficaci, ma con qualche difetto: la maggiore fonte di errore era proprio il passaggio dei

dati da un codice all'altro.

Per eliminare ogni possibile errore

dovuto alla cattiva comunicazione dei tre moduli tra loro sarebbe bastato riunire in un

unico codice l'intero processo di simulazione: soluzione quasi banale... a parole. Per eliminare ogni possibile errore

dovuto alla cattiva comunicazione dei tre moduli tra loro sarebbe bastato riunire in un

unico codice l'intero processo di simulazione: soluzione quasi banale... a parole.

La realizzazione pratica aveva però bisogno di interventi tutt'altro che banali.

Il processo, infatti, avrebbe comportato non solo l'ovvia riscrittura del software, ma la

ben più importante revisione dell'hardware per la potenza di calcolo che la nuova

simulazione avrebbe richiesto.

A portare a compimento l'intero processo ci ha pensato ancora un team del Los Alamos

National Laboratory, utilizzando la potenza di calcolo del supercomputer ASCII Blue

Mountain (vedi immagine) e dell'ASCI White Machine del Lawrence Livermore National

Laboratory.

Responsabili del progetto erano Galen Gisler e Bob Weaver del Los Alamos Thermonuclear

Application Group e Michael Gittings della Science Applications International Corporation.

I loro risultati sono stati presentati nel corso del Meeting dell'American Astronomical

Society tenutosi ad Albuquerque il 5 giugno 2002.

La simulazione ha preso in considerazione sei differenti scenari nei quali cambiavano le

dimensioni e la composizione del proiettile spaziale. La velocità dell'oggetto non era un

parametro variabile, ma era stata fissata in 20 km/s (72 mila km/h). Stessa scelta univoca

per la zona-bersaglio: un generico oceano con acque profonde 4500 metri.

Sei dunque le simulazioni effettuate, ciascuna caratterizzata da un differente valore del

diametro dell'oggetto (un chilometro, 500 metri e 250 metri) e della sua composizione

(metallica e rocciosa).

Galen Gisler, uno dei responsabili informatici

delle simulazioni, riassume così i risultati raggiunti: "Notizie buone e cattive

allo stesso tempo. Buone perchè dalle simulazioni risulta che l'onda provocata

dall'impatto viaggia circa il 25% più lentamente di quanto avevano previsto le precedenti

analisi. E questo potrebbe risultare fondamentale per consentire ad un maggior numero di

persone di spostarsi verso zone più elevate sfuggendo lo tsunami. La notizia cattiva è

purtroppo che l'altezza delle onde risulta raddoppiata rispetto alle precedenti

simulazioni."

Per essere più concreti: mentre la velocità dell'onda prevista da precedenti analisi era

di circa 800 km/h, nei nuovi calcoli si aggira intorno ai 600 km/h.

Gli stessi calcoli, poi, suggeriscono che l'onda iniziale potrebberaggiungere un'altezza

di circa 800 metri, ma questo valore si ridurrebbe di due terzi già a una sessantina di

chilometri dal punto dell'impatto.

Per seguire con precisione lo sviluppo dello tsunami dal punto d'impatto fino alla costa

più vicina era necessario costruire un modello che descrivesse al meglio le interazioni

tra acqua e aria e tra acqua e superficie dell'asteroide. Il modello doveva inoltre essere

in grado di seguire l'azione dell'onda d'urto che si diffondeva nell'oceano descrivendo

nei dettagli la propagazione delle onde di tsunami a varie distanze dalla loro origine.

La sfida più ardua per il team è stata l'accurata modellazione della propagazione delle

onde acustiche all'interno dell'asteroide al momento della sua vaporizzazione.

Inizialmente sembrava proprio un ostacolo insormontabile: l'impiego sia dei nuovi

programmi che di quelli precedenti forniva infatti risultati fisicamente inaccettabili.

Solo un successivo affinamento del codice ha permesso di descrivere accuratamente il moto

delle onde scustiche.

L'intera simulazione ha richiesto il calcolo di più di 200 milioni di distinte celle. Un'

enorme mole di calcoli che ha tenuto occupati per tre settimane i due supercomputer di Los

Alamos e del Lawrence Livermore Laboratory. Se fosse stato utilizzato un singolo

processore i calcoli l'avrebbero impegnato per oltre un milione di ore.

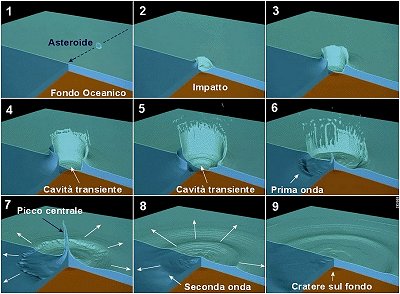

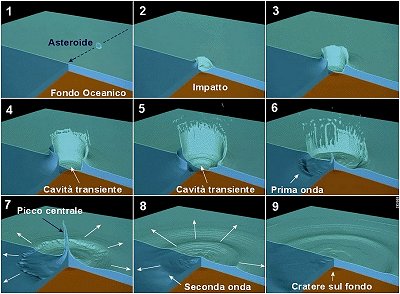

L'immagine qui proposta è stata realizzata

estraendo 9 fotogrammi significativi dal filmato della simulazione. Cliccando

sull'immagine si può accedere ad una versione più grande, mentre il filmato

originale (formato QuickTime) è scaricabile dal sito del Los Alamos National Laboratory

al link http://www.lanl.gov/worldview/news/tsunami.mov

|

Per eliminare ogni possibile errore

dovuto alla cattiva comunicazione dei tre moduli tra loro sarebbe bastato riunire in un

unico codice l'intero processo di simulazione: soluzione quasi banale... a parole.

Per eliminare ogni possibile errore

dovuto alla cattiva comunicazione dei tre moduli tra loro sarebbe bastato riunire in un

unico codice l'intero processo di simulazione: soluzione quasi banale... a parole.